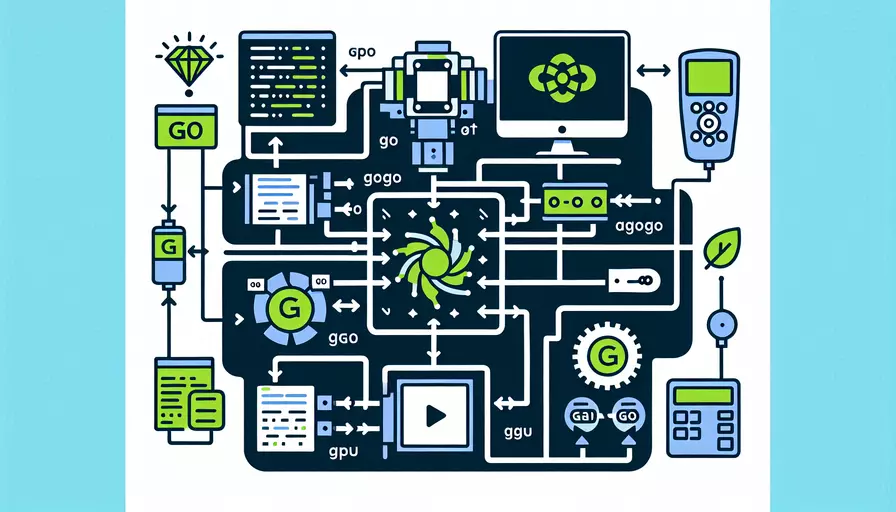

Go语言本身不直接支持GPU计算,但是可以通过结合C/C++库和使用CUDA、OpenCL等框架来实现GPU计算。1、使用Cgo、2、利用Go wrapper库、3、结合OpenCL或CUDA是几种常见的方法。接下来,我们将详细介绍其中一种方法,即使用Cgo和CUDA进行GPU计算。

一、使用Cgo

Cgo是Go语言的一种特殊工具,它允许Go代码调用C代码库。利用Cgo,我们可以将CUDA C代码嵌入到Go程序中,实现GPU计算。

-

安装CUDA:

首先,你需要在你的系统上安装CUDA。CUDA是由NVIDIA提供的并行计算平台和编程模型,专门为GPU计算设计。

-

编写CUDA C代码:

创建一个.cu文件,编写你的CUDA C代码。以下是一个简单的例子,用于在GPU上进行向量加法运算。

// vector_add.cuextern "C" void vectorAdd(const float *A, const float *B, float *C, int N);

__global__ void vectorAddKernel(const float *A, const float *B, float *C, int N) {

int i = blockIdx.x * blockDim.x + threadIdx.x;

if (i < N) {

C[i] = A[i] + B[i];

}

}

void vectorAdd(const float *A, const float *B, float *C, int N) {

float *d_A, *d_B, *d_C;

cudaMalloc((void)&d_A, N * sizeof(float));

cudaMalloc((void)&d_B, N * sizeof(float));

cudaMalloc((void)&d_C, N * sizeof(float));

cudaMemcpy(d_A, A, N * sizeof(float), cudaMemcpyHostToDevice);

cudaMemcpy(d_B, B, N * sizeof(float), cudaMemcpyHostToDevice);

int threadsPerBlock = 256;

int blocksPerGrid = (N + threadsPerBlock - 1) / threadsPerBlock;

vectorAddKernel<<<blocksPerGrid, threadsPerBlock>>>(d_A, d_B, d_C, N);

cudaMemcpy(C, d_C, N * sizeof(float), cudaMemcpyDeviceToHost);

cudaFree(d_A);

cudaFree(d_B);

cudaFree(d_C);

}

-

编写Go代码:

在Go代码中,使用Cgo来调用上面编写的CUDA C代码。

// main.go/*

#cgo LDFLAGS: -L/usr/local/cuda/lib64 -lcudart

#include "vector_add.cu"

*/

import "C"

import (

"fmt"

"unsafe"

)

func main() {

N := 1024

A := make([]float32, N)

B := make([]float32, N)

C := make([]float32, N)

// 初始化数据

for i := 0; i < N; i++ {

A[i] = float32(i)

B[i] = float32(i)

}

// 调用CUDA函数进行向量加法

C.vectorAdd((*C.float)(unsafe.Pointer(&A[0])), (*C.float)(unsafe.Pointer(&B[0])), (*C.float)(unsafe.Pointer(&C[0])), C.int(N))

// 打印结果

fmt.Println(C[:10])

}

二、利用Go wrapper库

使用现有的Go wrapper库可以极大简化GPU计算的实现过程。以下是一些常用的Go wrapper库:

-

gocudnn:

gocudnn是一个CUDA Deep Neural Network库的Go语言封装,可以方便地在Go中使用cuDNN库进行深度学习任务。

-

gorgonia:

gorgonia是一个类似于TensorFlow的Go语言计算图库,支持GPU加速。它提供了高层次的API,适合进行机器学习和深度学习任务。

-

cu:

cu是一个CUDA库的Go语言封装,提供了对CUDA的低层次访问,可以用于自定义GPU计算任务。

三、结合OpenCL或CUDA

OpenCL(Open Computing Language)是一种支持跨平台并行编程的框架,可以用于在不同硬件(包括GPU)上进行计算。通过使用OpenCL的Go绑定,可以实现跨平台的GPU计算。

-

安装OpenCL:

根据你的硬件和操作系统,安装相应的OpenCL驱动和SDK。

-

使用Go OpenCL库:

使用Go语言的OpenCL库(如

go-opencl)来编写GPU计算程序。package mainimport (

"fmt"

"github.com/go-opencl/cl"

)

func main() {

// 选择平台和设备

platforms, _ := cl.GetPlatforms()

platform := platforms[0]

devices, _ := platform.GetDevices(cl.DeviceTypeGPU)

device := devices[0]

// 创建上下文和命令队列

context, _ := cl.CreateContext([]*cl.Device{device})

queue, _ := context.CreateCommandQueue(device, 0)

// 编写OpenCL内核代码

kernelSource := `

__kernel void vectorAdd(__global const float *A, __global const float *B, __global float *C, int N) {

int i = get_global_id(0);

if (i < N) {

C[i] = A[i] + B[i];

}

}`

program, _ := context.CreateProgramWithSource([]string{kernelSource})

program.Build(nil, "")

kernel, _ := program.CreateKernel("vectorAdd")

// 初始化数据

N := 1024

A := make([]float32, N)

B := make([]float32, N)

C := make([]float32, N)

for i := 0; i < N; i++ {

A[i] = float32(i)

B[i] = float32(i)

}

// 创建缓冲区

bufferA, _ := context.CreateBuffer(cl.MemReadOnly, N*4)

bufferB, _ := context.CreateBuffer(cl.MemReadOnly, N*4)

bufferC, _ := context.CreateBuffer(cl.MemWriteOnly, N*4)

// 写入缓冲区

queue.EnqueueWriteBufferFloat32(bufferA, true, 0, A, nil)

queue.EnqueueWriteBufferFloat32(bufferB, true, 0, B, nil)

// 设置内核参数

kernel.SetArgs(bufferA, bufferB, bufferC, N)

// 执行内核

globalWorkSize := []int{N}

queue.EnqueueNDRangeKernel(kernel, nil, globalWorkSize, nil, nil)

queue.Finish()

// 读取结果

queue.EnqueueReadBufferFloat32(bufferC, true, 0, C, nil)

fmt.Println(C[:10])

}

通过这些方法,Go程序员可以利用GPU的强大计算能力,大幅提升计算任务的性能。

总结

使用Go进行GPU计算主要有三种途径:1、使用Cgo,2、利用Go wrapper库,3、结合OpenCL或CUDA。每种方法都有其适用的场景和优劣。对于需要高性能计算的任务,如深度学习、图像处理等,建议选择合适的方法来实现GPU加速,以显著提升计算效率。进一步的建议是根据具体的需求和硬件配置选择合适的库和工具,定期更新和维护相关库,以确保兼容性和性能的最优化。

相关问答FAQs:

1. Go语言如何使用GPU进行计算?

Go语言是一种快速、简洁且易于使用的编程语言,虽然它本身不直接提供对GPU的支持,但我们可以通过第三方库来实现在Go语言中使用GPU进行计算。

目前,有几个流行的第三方库可以帮助我们在Go语言中使用GPU,其中最常用的是CUDA和OpenCL。

-

CUDA是由NVIDIA开发的并行计算平台和编程模型,它可以让我们利用NVIDIA GPU的强大计算能力。在Go语言中,可以使用Go语言的CUDA绑定库来实现对CUDA的支持。这个库提供了一组用于在Go语言中调用CUDA函数的API,并且可以与Go的并发模型很好地集成。

-

OpenCL是一个开放的并行计算框架,可以在不同类型的硬件上进行通用并行计算。在Go语言中,可以使用Go语言的OpenCL绑定库来实现对OpenCL的支持。这个库提供了一组用于在Go语言中调用OpenCL函数的API,并且可以与Go的并发模型很好地集成。

在使用这些库之前,首先需要安装相应的GPU驱动和运行时环境。然后,可以通过引入相关库的包来在Go语言中进行GPU计算。具体的使用方法可以参考相关库的文档和示例代码。

2. GPU计算有什么优势和应用场景?

GPU(图形处理器)是一种专用的处理器,用于处理图形和并行计算任务。相对于传统的中央处理器(CPU),GPU具有以下优势:

-

并行计算能力:GPU拥有大量的处理单元,可以同时执行大量的计算任务。这使得GPU在处理大规模数据和高并发计算时具有明显的优势。

-

强大的浮点计算能力:GPU在浮点计算方面具有超高的性能,特别适用于科学计算、机器学习、深度学习等需要大量浮点计算的领域。

-

高效的能耗比:相对于CPU,GPU在单位能耗下可以提供更高的计算性能。这使得GPU成为节能计算和绿色计算的重要选择。

基于以上的优势,GPU在许多领域都有广泛的应用,包括但不限于:

-

科学计算:GPU可以加速各种科学计算任务,如数值模拟、天气预测、量子化学计算等。

-

机器学习和深度学习:由于机器学习和深度学习中存在大量的矩阵运算和向量计算,GPU可以极大地加速这些任务,提高训练和推断的效率。

-

金融分析:金融领域中的大规模数据分析和计算也可以借助GPU来加速,例如风险评估、投资组合优化等。

-

游戏开发和图形渲染:GPU最初是为图形处理而设计的,因此在游戏开发和图形渲染方面有着广泛的应用。

3. 如何在Go语言中优化GPU计算性能?

在使用GPU进行计算时,我们可以采取一些优化策略来提高计算性能,以充分利用GPU的并行计算能力。以下是一些优化策略的示例:

-

数据复用:尽量减少数据从主机内存到GPU内存的传输次数,可以通过复用计算结果或使用共享内存等方式来实现。

-

并行化:将计算任务分解为多个并行的子任务,利用GPU的并行计算能力同时执行这些子任务。可以使用Go语言的并发模型来实现任务的并行化。

-

内存访问优化:合理地利用GPU的内存层次结构,尽量减少内存访问的延迟。可以使用局部性原理、数据对齐等技术来优化内存访问。

-

算法优化:选择适合GPU并行计算的算法,尽量减少计算任务的复杂度和数据依赖性。可以通过使用并行化算法、减少不必要的计算等方式来优化算法。

-

GPU资源管理:合理地管理GPU的资源,包括内存、线程等。可以使用GPU的内存池、线程池等技术来管理资源的分配和释放。

以上是一些常见的优化策略,具体的优化方法和技巧可以根据具体的应用场景和需求进行选择和实现。在实际开发中,可以通过不断地测试和调优来提高GPU计算性能。

文章标题:go语言如何使用gpu进行计算,发布者:不及物动词,转载请注明出处:https://worktile.com/kb/p/3500106

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫